“우리는 어떤 도덕적 가치들을 채택하고 어떤 도덕적 입장을 취할 것인지를 결정해야 한다.”- John Mackie(1977)

- 존매키(John Mackie)에 의하면, 도덕은 옳고 그름(선악)의 선택이라고 할 수 있다. 과거 선악을 판단하는 것은 신의 영역이었고, 이제는 판사의 영역이기도 하다. 그러나, 모든 영역을 판사에게 맡기기는 어려운 상황에 직면하고 있다. 인공지능이 사회의 작지 않은 영역에 들어서면서 새로운 고민을 주기 때문이다. 인공지능에 대한 대응체계 중 하나가 윤리이다. 인공지능은 윤리를 학습할 수 있는가? 쉬운 질문이기도 하지만, 답을 찾기 어려운 질문이기도 하다. 이러한 면에서 인공지능 연구는 인간에 대한 성찰이 필요한 학문이자, 응용윤리이기도 하다.

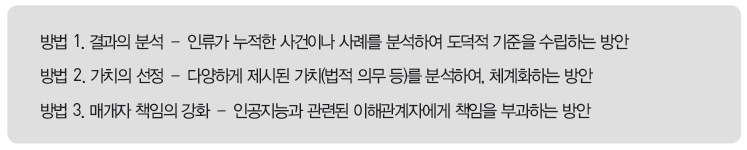

- 윤리연구는 기술적 도덕, 도덕철학, 응용윤리 등을 다룬다. 도덕철학은 옳고 그름에 대한 가치를 분석하고, 응용윤리는 하나의 사안에 대해 도덕철학을 적용하는 것이다. 이처럼 윤리연구는 서로 분리된 연구가 아니라는 것이다. 본 발표는 윤리를 인공지능이 학습할 수 있는지, 또는 프로그래밍으로 가능한지에 대한 고민이자, 미완의 결과이다.